Les chercheurs de la NASA peuvent entendre ce que vous dites, même si vous ne faites pas de bruit.

Dans l’espace, personne ne peut vous entendre crier. Utilisez un téléphone portable dans un train de banlieue bondé et tout le monde peut le faire.

Charles Jorgensen s’efforce de résoudre ces deux problèmes, en utilisant une étrange technologie appelée reconnaissance vocale subvocale. Jorgensen en fait la démonstration dans ses bureaux de l’Ames Research Laboratory de la NASA à Mountain View, en Californie. Il fixe un ensemble d’électrodes sur la peau de sa gorge et, sans qu’il n’ouvre la bouche ou n’émette de son, ses mots sont reconnus et commencent à apparaître sur un écran d’ordinateur. Le laboratoire d’Ames a déjà utilisé des commandes vocales pour conduire une voiture dans une ville virtuelle dans une simulation informatique et pour Google (nasdaq : GOOG – news – people ) le Web en n’utilisant que des termes de recherche et des commandes simples. Jorgensen voit de nombreuses applications pour sa technologie là où la parole audible est impossible : pour les astronautes, les sous-marins de la marine, les pilotes de chasse et les secouristes qui se déplacent dans des environnements bruyants et difficiles.

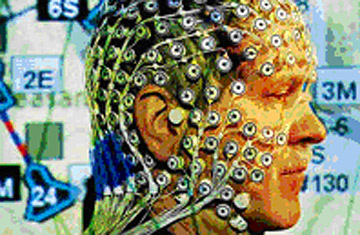

Lorsque nous parlons à haute voix, nous forçons l’air à passer le larynx et la langue, sculptant les mots en utilisant les muscles articulateurs de la bouche et de la mâchoire. Mais ces muscles entrent en action, que de l’air soit envoyé ou non devant eux. Tout ce que vous avez à faire est de vous dire les mots et vous envoyez de faibles courants électriques de votre cerveau aux muscles de la parole. L’astuce de Jorgensen consiste à enregistrer ces signaux (appelés électromyogrammes), à les traiter à l’aide d’algorithmes statistiques et à comparer la sortie avec des modèles de signaux préenregistrés de mots, phrases et commandes parlés. Lorsqu’il y a correspondance, le non-dit se transforme en parole.

Jorgensen, qui a obtenu un doctorat en psychologie mathématique en 1974 (avant qu’il ne soit connu sous le nom d’intelligence artificielle), a eu l’idée de la reconnaissance vocale subvocale après avoir travaillé sur des interfaces électromyographiques pour les pilotes de chasse. Ces travaux nous ont amenés à nous poser la question suivante : « Quelle est la puissance d’un courant électromagnétique que nous pouvons discriminer », explique Jorgensen. (Le fait que les nerfs produisent du courant est connu depuis 1848, date à laquelle Emil DuBois-Reymond s’est ouvert la main et a plongé son poing serré dans une solution saline, déclenchant un saut dans un galvanomètre attaché).

La reconnaissance vocale subvocale a encore besoin de beaucoup de travail avant de pouvoir obtenir des lectures cohérentes et précises. Les logiciels de reconnaissance vocale auditive sont désormais suffisamment performants pour convertir à la fois « tom-ah-to » et « tom-ay-to » en « tomate ». Dans des conditions optimales, un logiciel de reconnaissance vocale normal qui fonctionne avec des sons est précis à 95 %.

Mais la reconnaissance subvocale traite des électromyogrammes qui sont différents pour chaque locuteur. La cohérence peut être perturbée par le simple positionnement d’une électrode. Pour améliorer la précision, les chercheurs dans ce domaine s’appuient sur des modèles statistiques qui s’améliorent avec le nombre de fois qu’un sujet « parle » à travers les électrodes. Mais même dans ce cas, il y a des défaillances. À l’université Carnegie Mellon, les chercheurs ont découvert qu’un même « locuteur » avec un taux de précision de 94% un jour peut voir ce taux chuter à 48% un jour plus tard. Entre deux locuteurs différents, ce taux chute encore plus.

Selon Tanja Schultz, chercheuse à Carnegie Mellon, une application possible est un téléphone portable « silencieux » qui peut détecter et traduire des phrases simples comme « je suis en réunion » et « je vous appellerai plus tard ». Le Japonais NTT Docomo travaille sur un téléphone portable subvocal actionné par des capteurs portés sur les doigts et le pouce. Un locuteur s’agrippe au visage, mettant les capteurs en contact avec la pommette, la lèvre supérieure et le menton. Jusqu’à présent, le système de Docomo reconnaît les cinq voyelles japonaises 90 % du temps.

Jorgensen voit le jour où des capteurs électromagnétiques seront tissés dans les fibres des cols roulés ou des tenues des secouristes. « Tant que les gens ont eu des machines et des outils, ils ont été dépendants de la physique du corps », dit Jorgensen. « Séparer ces activités de contrôle du corps et cela ouvre une toute nouvelle génération de conception des interfaces ».

David Armstrong 04.10.06 NASA researchers can hear what you’re saying, even when you don’t make a sound.

Sauvegarde : The Silent Speaker – Forbes.com